Dünya Ekonomik Forumu’na (WEF) göre çevrimiçi deepfake videoların sayısı her yıl %900 oranında artıyor. Taciz, intikam ve kripto dolandırıcılığı ile ilgili raporlarla birlikte birçok önemli deepfake dolandırıcılık vakası haber manşetlerine çıktı. Kaspersky araştırmacıları, kullanıcıların dikkat etmesi gereken ve deepfake kullanan ilk üç dolandırıcılık planına ışık tutuyor.

Yapay sinir ağlarının, derin öğrenmenin ve dolayısıyla deepfake aldatma tekniklerinin kullanımı, dünyanın dört bir yanındaki kullanıcıların yüzlerini veya vücutlarını dijital olarak değiştirmeye, böylece herhangi birinin başka biri gibi göründüğü gerçekçi görüntü, video ve ses materyallerini üretmeye olanak sağlıyor. Bu manipüle edilmiş video ve görüntüler sıklıkla yanlış bilgi yaymak ve diğer kötü niyetli amaçlarla kullanılıyor.

Finansal dolandırıcılık

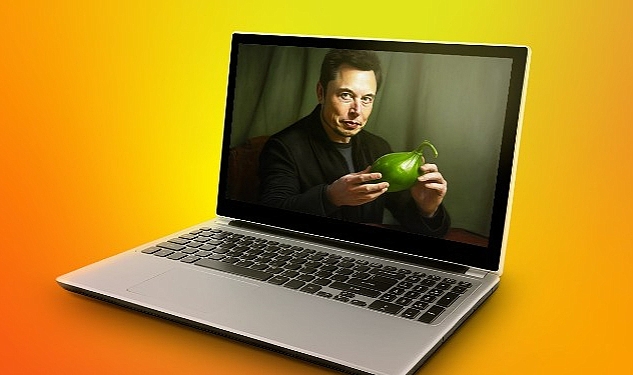

Deepfake’ler, suçluların kurbanları tuzağa çekmek amacıyla ünlüleri taklit etmek için geliştirdikleri görüntülerin kullanıldığı sosyal mühendislik tekniklerine konu olabiliyor. Örneğin Elon Musk’ın şüpheli bir kripto para yatırım planından yüksek getiri vaat eden yapay olarak oluşturulmuş bir videosu, geçen yıl hızla yayılarak kullanıcıların para kaybetmelerine neden oldu. Dolandırıcılar bunun gibi sahte videolar yaratmak için ünlülerin görüntülerini kullanıyor, eski videoları bir araya getiriyor ve sosyal medya platformlarında canlı yayınlar başlatarak kendilerine gönderilen herhangi bir kripto para ödemesini iki katına çıkarma sözü veriyor.

Pornografik deepfake

Deepfake’lerin bir başka kullanım alanı da bireyin mahremiyetini ihlal etmek. Deepfake videolar, bir kişinin yüzünün pornografik bir video üzerine yerleştirilmesiyle oluşturulabiliyor ve büyük zarara ve sıkıntıya neden olabiliyor. Bir vakada, bazı ünlülerin yüzlerinin müstehcen sahnelerdeki pornografik aktrislerin vücutlarına bindirildiği deepfake videolarının internette yayıldığı ortaya çıktı. Sonuç olarak, bu tür vakalarda saldırı mağdurlarının itibarları zedeleniyor ve hakları ihlal ediliyor.

İşe dair riskler

Çoğu zaman deepfake’ler şirket yöneticilerinden haraç alma, şantaj ve endüstriyel casusluk gibi suçlar için işletmeleri hedef almak üzere kullanılıyor. Örneğin, siber suçlular bir ses deepfake’i kullanarak BAE’deki bir banka müdürünü kandırmayı ve 35 milyon dolar çalmayı başarmıştı. Söz konusu vakada ikna edici bir deepfake oluşturmak için patronunun sesinin sadece küçük bir kaydının ele geçirilmesi yeterliydi. Bir başka vakada, dolandırıcılar en büyük kripto para platformu Binance’i kandırmaya çalıştı. Binance yöneticisi, hiç katılmadığı bir Zoom toplantısı hakkında “Teşekkür ederim!” mesajları almaya başladığında şaşırdı. Saldırganlar, yöneticinin herkese açık görüntüleriyle bir deepfake oluşturmayı ve bunu çevrimiçi bir toplantıda yönetici adına konuşarak uygulamayı başardılar.

FBI, insan kaynakları yöneticilerini uyarıyor!

Genel olarak, deepfake’leri kullanan dolandırıcıların amaçları arasında dezenformasyon ve kamuoyunu manipüle etme, şantaj ve casusluk yer alıyor. Bir FBI uyarısına göre, insan kaynakları yöneticileri uzaktan çalışmak için başvuran adaylar tarafından deepfake kullanımı konusunda zaten tetikte bekliyor. Binance vakasında, saldırganlar deepfake oluşturmak için internetten gerçek kişilerin görüntüleri kullandılar ve hatta bu kişilerin fotoğraflarını özgeçmişlere eklediler. İnsan kaynakları yöneticilerini bu şekilde kandırmayı başarırlarsa ve sonrasında bir teklif alırlarsa, devamında işveren verilerini çalabiliyorlar.

Deepfake’ler büyük bir bütçe gerektiren ve sayıları giderek artan pahalı bir dolandırıcılık türü olmaya devam ediyor. Kaspersky tarafından daha önce yapılan bir araştırma, darknet üzerindeki deepfake’lerin maliyetini ortaya koyuyor. Sıradan bir kullanıcı internette bir yazılım bulur ve bir deepfake yapmaya çalışırsa, sonuç gerçekçi olmayacak ve sahtekarlık bariz oluyor. Çok az insan düşük kaliteli bir deepfake’e inanıyor. Yüz ifadesindeki gecikmeleri veya çene şeklindeki bulanıklığı hemen fark edebiliyor.

Bu nedenle, siber suçlular bir saldırıya hazırlanırken büyük miktarda veriye ihtiyaç duyuyor. Taklit etmek istedikleri kişinin fotoğrafları, videoları ve sesleri gibi. Farklı açılar, ışık parlaklığı, yüz ifadeleri, hepsi nihai kalitede büyük rol oynuyor. Sonucun gerçekçi olması için güncel bir bilgisayarın gücü ve yazılımı gerekiyor. Tüm bunlar büyük miktarda kaynak gerektiriyor ve bu kaynağa yalnızca az sayıda siber suçlu erişebiliyor. Bu nedenle deepfake sağlayabileceği tehlikelere rağmen hala son derece nadir bir tehdit olmaya devam ediyor ve yalnızca az sayıda alıcı bunu karşılayabiliyor. Netice olarak bir dakikalık bir “deepfake’in fiyatı 20 bin ABD dolarından başlıyor.

“Bazen itibar riskleri çok ciddi sonuçlar doğurabilir”

Kaspersky’de Kıdemli Güvenlik Uzmanı Dmitry Anikin, şunları söylüyor: “Deepfake’in işletmeler için oluşturduğu en ciddi tehditlerden biri her zaman kurumsal verilerin çalınması değildir. Bazen itibar riskleri çok ciddi sonuçlar doğurabilir. Yöneticinizin (görünüşe göre) hassas konularda kutuplaştırıcı açıklamalar yaptığı bir videonun yayınlandığını düşünün. Şirket için bu durum hisse fiyatlarında hızlı bir düşüşe yol açabilir. Ancak, böyle bir tehdidin riskleri son derece yüksek olmasına rağmen, deepfake oluşturmanın maliyeti ve çok az saldırganın yüksek kaliteli bir deepfake oluşturabilmesi nedeniyle bu şekilde saldırıya uğrama şansınız son derece düşüktür. Bu konuda yapabileceğiniz şey, deepfake videoların temel özelliklerinin farkında olmak ve size gelen sesli mesaj ve videolara şüpheyle yaklaşmaktır. Ayrıca, çalışanlarınızın deepfake’in ne olduğunu ve nasıl fark edebileceklerini anladıklarından emin olun. Örneğin sarsıntılı hareket, cilt tonunda kaymalar, garip göz kırpma veya hiç göz kırpmama gibi işaretler belirleyici olacaktır.”

Darknet kaynaklarının sürekli olarak izlenmesi, deepfake endüstrisi hakkında değerli bilgiler sağlayarak araştırmacıların bu alandaki tehdit aktörlerinin en son eğilimlerini ve faaliyetlerini takip etmelerine olanak sağlıyor. Araştırmacılar darknet’i izleyerek deepfake’lerin oluşturulması ve dağıtımı için kullanılan yeni araçları, hizmetleri ve pazar yerlerini ortaya çıkarabiliyor. Bu tür bir izleme, deepfake araştırmasının kritik bir bileşenini oluşturuyor ve gelişen tehdit ortamına ilişkin anlayışımızı geliştirmemize yardımcı oluyor. Kaspersky Dijital Ayak İzi İstihbaratı hizmeti, müşterilerinin deepfake ile ilgili tehditler söz konusu olduğunda bir adım önde olmalarına yardımcı olmak için bu tür bir izleme içeriyor.

Kaspersky Daily’de deepfake endüstrisi hakkında daha fazla bilgi edinebilirsiniz.

Kaspersky, deepfake’lerle ilgili tehditlerden korunmak için şunları öneriyor:

- Kuruluşunuzdaki siber güvenlik uygulamalarını kontrol edin- yalnızca yazılım açısından değil, gelişmiş BT becerileri açısından da. Mevcut tehdit ortamının önüne geçmek için Kaspersky Threat Intelligence kullanın.

- Kurumsal “insan güvenlik duvarını” güçlendirin. Çalışanlarınızın deepfake’in ne olduğunu, nasıl çalıştıklarını ve oluşturabilecekleri zorlukları anladığından emin olun. Çalışanlara bir deepfake’i nasıl tespit edeceklerini öğretmek için sürekli farkındalık ve eğitim çalışmaları yapın. Kaspersky Automated Security Awareness Platform, çalışanların en yeni tehditler konusunda güncel kalmasına yardımcı olur ve dijital okuryazarlık seviyelerini artırır.

- Kaliteli haber kaynaklarına başvurun. Cehalet ve bilgi eksikliği deepfake’lerin yaygınlaşmasında önemli bir etken olmaya devam etmektedir.

- ‘Güven ama doğrula’ gibi sağlam protokolleri devreye alın. Sesli mesaj ve videolara şüpheyle yaklaşmak insanların asla kandırılmayacağını garanti etmez, ancak yaygın tuzakların çoğundan kaçınmaya yardımcı olabilir.

- Deepfake kurbanı olmamak için videoların dikkat edilmesi gereken temel özelliklerinin farkında olun. Sarsıntılı hareket, bir kareden diğerine ışıkta kaymalar, cilt tonunda değişimler, garip göz kırpmalar veya hiç göz kırpmama, konuşmayla uyum sağlamayan dudaklar, görüntüdeki dijital yapaylıklar, kasıtlı olarak düşük kalitede kodlanmış ve zayıf aydınlatmaya sahip videolar gibi.

Kaynak: (BYZHA) Beyaz Haber Ajansı